CVPR2021目标检测和语义分割论文分类汇总 | 源码 |

编辑丨迈微AI研习社

今年CVPR 共有7015篇有效投稿,其中进入Decision Making阶段的共有约5900篇,最终有1663篇突出重围被接收,录用率大概为23.7%(1663/7015)。

本周开始我将为大家持续分享最新的CVPR2021论文解读,本篇文章收录了目标检测和语义分割的最新论文合集,以最快的形式发送给需要阅读的迈微社友,每篇文章会给出论文链接以及作者开源的代码。

目标检测篇

1、Semantic Relation Reasoning for Shot-Stable Few-Shot Object Detection

paper链接:https://arxiv.org/abs/2103.01903

由于真实世界数据固有的长尾分布,few-shot目标检测是一个重要而持久的问题。它的性能很大程度上受到新类数据稀缺的影响。但是无论数据的可用性如何,新类和基类之间的语义关系都是不变的。这篇paper研究了如何利用这种语义关系和视觉信息,并将显式关系推理引入到新目标检测的学习中。

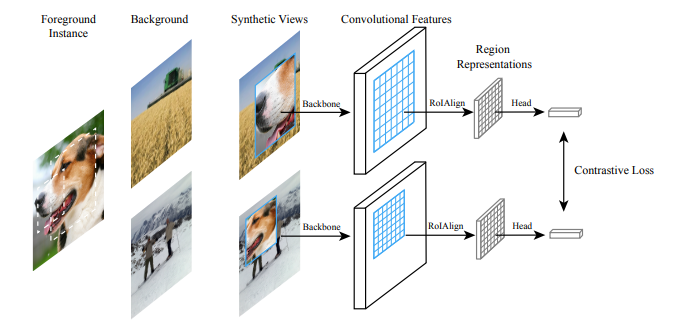

2、Instance Localization for Self-supervised Detection Pretraining(香港大学,微软亚洲研究院)

paper链接:https://arxiv.org/pdf/2102.08318.pdf

以往对自监督学习的研究在图像分类方面取得了相当大的进展,但在目标检测方面往往存在transfer性能下降的问题。本文的目的是提出一种专门用于目标检测的自监督预训练模型。

3、Towards Open World Object Detection

paper链接:https://arxiv.org/abs/2103.02603

解读文章:新视觉任务!CVPR 2021 Oral | OWOD:面向开放世界的目标检测

人类有识别环境中未知物体实例的本能。人类有一种自然的本能来识别未知环境中的物体实例。这促使作者提出了一个新的计算机视觉问题,称为“开放世界目标检测”,模型的任务是:

1)在没有明确监督的情况下,将尚未引入的目标识别为“未知”,

2)逐步学习这些已识别的未知类别,而不忘记以前学习的类,当相应的标签逐渐收到时。

本文提出了一种基于对比聚类和基于能量的未知识别的开放世界目标检测算法。

4、Positive-Unlabeled Data Purification in the Wild for Object Detection

暂未放出

5、General Instance Distillation for Object Detection

paper链接:https://arxiv.org/pdf/2103.02340.pdf

近年来,知识蒸馏被证明是一种有效的模型压缩方法。这种方法可以使轻量级的学生模型从较大的教师模型中获取知识。然而,以往的提取检测方法对不同检测框架的泛化能力较弱,严重依赖于GT,忽略了实例间有价值的关系信息。因此,论文提出了一种新的基于区分性实例的提取方法,即一般实例提取(GID)。该方法包含了通用实例选择模块(GISM),充分利用了基于特征、基于关系和基于响应的知识进行提取。

6、UP-DETR: Unsupervised Pre-training for Object Detection with Transformers

paper链接:https://arxiv.org/pdf/2011.09094.pdf

知乎讨论贴 https://www.zhihu.com/question/432321109/answer/1606004872

transformer+无监督的一篇paper。

7、Depth from Camera Motion and Object Detection

paper链接:https://arxiv.org/abs/2103.01468

本文讨论了在给定摄像机运动测量值(如机器人运动学或车辆里程计)的情况下,学习估计被测物体深度的问题。论文通过1)设计一个递归神经网络(DBox),使用box和未校准摄像机运动的广义表示来估计物体的深度;2)通过运动和检测数据集(ODMD)引入物体深度。

8、There is More than Meets the Eye: Self-Supervised Multi-Object Detection and Tracking with Sound by Distilling Multimodal Knowledge

paper链接:https://arxiv.org/abs/2103.01353

物体固有的声音属性可以为学习丰富的物体检测和跟踪表示提供有价值的线索。此外,可以利用视频中视听事件的同时出现,通过单独监测环境中的声音,在图像场上定位对象。到目前为止,这只适用于摄像机静止和单目标检测的场景。此外,这些方法的鲁棒性受到限制,因为它们主要依赖于对光照和天气变化非常敏感的RGB图像。在这项工作中,作者提出了一个新颖的自监督MM-stewartnet框架,该框架由多个教师组成,他们利用不同的模式,包括RGB、深度和热图像,同时利用互补线索并将知识提取到单一音频学生网络中。

9、Dogfight: Detecting Drones from Drone Videos

暂未放出

10、3DIoUMatch: Leveraging IoU Predictionfor Semi-Supervised 3D Object Detection

paper链接:https://arxiv.org/pdf/2012.04355.pdf

三维目标检测是一项重要而艰巨的任务,它严重依赖于难以获得的三维标注。为了减少所需的监督量,论文提出了一种新的半监督三维物体检测方法。采用VoteNet(一种流行的基于点云的目标检测器)作为主干,利用一个教师学生互学习网络框架,以伪标签的形式将信息从标注训练集传播到无标注训练集。

11、Categorical Depth Distribution Network for Monocular 3D Object Detection

paper链接:https://arxiv.org/abs/2103.01100

单目三维目标检测是自动驾驶领域的一个关键问题,与典型的多传感器系统相比,它提供了一种结构简单的解决方案。单目三维检测的主要挑战在于准确预测目标深度,由于缺乏直接的距离测量,必须从目标和场景线索中推断出目标深度。许多方法试图直接估计深度来辅助三维检测,但由于深度不准确,性能有限。论文提出的分类深度分布网络(Categorical Depth Distribution Network,CaDDN)利用每个像素的预测分类深度分布,将丰富的上下文特征信息投射到三维空间中适当的深度区间。然后,使用计算效率高的鸟瞰投影和单级检测器来生成最终的输出边界框。作者将CaDDN设计为一种完全可微的端到端方法,用于联合深度估计和目标检测。

12、Multiple Instance Active Learning for Object Detection(用于对象检测的多实例主动学习

paper链接:https://github.com/yuantn/MIAL/raw/master/paper.pdf

源码链接:https://github.com/yuantn/MIAL

13、Re-labeling ImageNet: from Single to Multi-Labels, from Global to Localized Labels(重新标记ImageNet:从单标签到多标签,从全局标签到本地标签)

paper链接:https://arxiv.org/pdf/2101.05022.pdf

源码链接:https://github.com/naver-ai/relabel_imagenet

单标签注释和有效多标签图像之间的不匹配在采用随机作物的训练设置中同样(甚至更多)存在问题。使用单标签注释,图像的随机裁剪可能包含与地面真实情况完全不同的对象,从而在训练期间引入了嘈杂甚至不正确的监控。因此,用多标签重新标记了ImageNet训练集。作者通过让经过额外数据源训练的强大图像分类器生成多个标签,来解决注释成本的障碍。为了利用附加的特定于位置的监督信号,在最终合并层之前利用了逐像素的多标签预测。

14、Rethinking Channel Dimensions for Efficient Model Design(重新考虑通道尺寸以进行有效的模型设计)

paper链接:https://arxiv.org/pdf/2007.00992.pdf

源码链接:https://github.com/clovaai/rexnet

本文解决了网络中的代表性瓶颈,并提出了一组可显着提高模型性能的设计原则。作者认为,代表性的瓶颈可能会出现在由常规设计设计的网络中,并导致模型性能下降。为了研究代表性瓶颈,他们研究了由上万个随机网络生成的特征的矩阵等级。作者将进一步研究整个层的通道配置,以设计更准确的网络体系结构。基于调查,作者提出了简单而有效的设计原则来减轻代表性瓶颈。遵循该原则对基准网络进行的细微更改将导致ImageNet分类的显着性能改进。此外,COCO对象检测结果和多个数据集上的转移学习结果还为减少网络的代表性瓶颈与提高性能之间的链接提供了其他备份。

15、OPANAS: One-Shot Path Aggregation Network Architecture Search for Object(一键式路径聚合网络体系结构搜索对象)

paper链接:https://arxiv.org/pdf/2103.04507.pdf

源码链接:https://github.com/VDIGPKU/OPANAS

最近,神经体系结构搜索(NAS)已被用于设计特征金字塔网络(FPN),并在视觉对象检测方面取得了可喜的成果。在成功的鼓舞下,我们提出了一种新颖的单发路径聚合网络体系结构搜索(OPANAS)算法,该算法可显着提高搜索效率和检测精度。

具体来说,我们首先介绍了六个异构信息路径来构建我们的搜索空间,即自上而下,自下而上,融合拆分,比例均衡,跳过连接和无。

其次,我们提出了一种新颖的FPN搜索空间,其中每个FPN候选对象都由紧密连接的有向无环图表示(每个节点是一个特征金字塔,每个边都是六个异构信息路径之一)。

第三,我们提出了一种有效的单次搜索方法,以找到最佳的路径聚合体系结构,即,我们首先训练一个超级网络,然后使用进化算法找到最佳的候选者。

实验结果证明了所提出的OPANAS对物体检测的功效:

(1)OPANAS比最先进的方法(例如NAS-FPN和Auto-FPN)效率更高,但搜索成本却要低得多(例如,在MS-COCO上只有4个GPU天);

(2)OPANAS发现的最佳架构显着地改善了包括RetinaNet,Faster R-CNN和Cascade R-CNN在内的主流检测器,与FPN同类检测器相比,提高了2.3%至3.2%的mAP。

(3)一种新的,最先进的精度与速度的权衡(在7.6 FPS时,mAP为52.2%),而培训费用却比同类同类产品要小。代码将在发布。

16、MeGA-CDA: Memory Guided Attention for Category-Aware Unsupervised Domain Adaptive Object Detection(用于类别识别无监督域自适应对象检测)

paper链接:https://arxiv.org/pdf/2007.00992.pdf

源码链接:https://github.com/clovaai/rexnet

用于无监督域自适应对象检测的现有方法通过对抗训练来执行特征对准。尽管这些方法在性能上实现了合理的改进,但它们通常执行与类别无关的域对齐,从而导致特征的负传递。为了克服这个问题,在这项工作中,我们尝试通过提出针对类别感知的域自适应的内存引导注意(MeGA-CDA),将类别信息纳入域自适应过程。所提出的方法包括采用按类别的鉴别器以确保用于学习领域不变的鉴别特征的基于类别的特征对齐。但是,由于类别信息不适用于目标样本,因此我们建议生成内存导向的类别特定注意图,然后将其用于将特征适当地路由到相应的类别识别符。在几种基准数据集上对提出的方法进行了评估,结果表明该方法优于现有方法。

这篇文章的解读分析将在本周安排分享。

语义/实例全景/分割篇

1、PointFlow: Flowing Semantics Through Points for Aerial Image Segmentation

暂未开放

相似论文:PointFlow: 3D Point Cloud Generation with Continuous Normalizing Flows

论文链接 https://arxiv.org/abs/2012.06166

代码链接 https://github.com/stevenygd/PointFlow

2、Few-Shot Segmentation Without Meta-Learning: A Good Transductive Inference Is All You Need?

paper链接:https://arxiv.org/abs/2012.06166

源码链接:https://github.com/mboudiaf/RePRI-for-Few-Shot-Segmentation

Few-Shot分割方法最近引起了人们的极大兴趣,流行的元学习范式在文献中占据了主导地位。作者介绍了一种转导推断,它通过优化包含三个互补项的新损失来利用任务中未标记像素的统计信息:(i)标记像素的标准交叉熵;(ii)在未标记的查询像素上后验的熵;(iii)基于预测前景区域的比例的全局KL散度正则化器。

本文推理使用提取特征的简单线性分类器,具有与归纳推理相当的计算量,可用于任何基础训练。在基类上使用标准的交叉熵训练,作者的推论在众所周知的几次分割基准上产生了极具竞争力的表现1。在PASCAL5 i上,与5幅镜头方案中性能最佳的最新方法相比,它带来了5%的改进,而在1幅镜头设置中则达到了同等水平。更令人惊讶的是,这种差距随着支持样本数量的增加而扩大,在10次注入情况下达到6%。此外,本文引入了一个更现实的域偏移设置,其中基类和新颖类是从不同的数据集中提取的。在这种情况下,发现该方法可以达到最佳性能。

3、4D Panoptic LiDAR Segmentation

时态语义场景理解是自动驾驶车辆或机器人在动态环境中工作的关键。本文提出了4D全景激光雷达分割来分配一个语义类和一个时间上一致的实例ID到一个3D点序列。

论文链接 https://arxiv.org/pdf/2102.12472.pdf

论文链接 https://arxiv.org/abs/1911.11236

代码链接 https://github.com/QingyongHu/RandLA-Net

4、Towards Semantic Segmentation of Urban-Scale 3D Point Clouds: A Dataset, Benchmarks and Challenges

paper链接:https://arxiv.org/abs/2102.12472

源码链接 https://github.com/QingyongHu/SensatUrban

5、PLOP: Learning without Forgetting for Continual Semantic Segmentation

paper链接:https://arxiv.org/abs/2011.11390

目前,深度学习方法广泛应用于处理语义分割等需要大量数据集和强大计算能力的计算机视觉任务。语义连续学习(CSS)是一个新兴的趋势,它通过不断地添加新的语义来更新旧的模型语义。本文提出了一种多尺度池蒸馏方案localpod,该方案在特征级保持长、短距离的空间关系。此外,还设计了一个基于熵的伪标号来处理由旧模型预测的背景类,以避免旧类的灾难性遗忘。该方法方法称为PLOP,在现有CSS场景中,以及在新提出的具有挑战性的基准中,大大超过了最先进的方法。

6、End-to-End Video Instance Segmentation with Transformers

paper链接:https://arxiv.org/abs/2011.14503

使用Transformers进行视频实例分割~

视频实例分割(VIS)是一项需要同时对视频中感兴趣的对象实例进行分类,分割和跟踪的任务。最近的方法通常开发复杂的管道来解决此任务。在这里,作者提出了一个基于Transformers的新视频实例分割框架,称为VisTR,该框架将VIS任务视为直接的端到端并行序列解码/预测问题。给定包含多个图像帧的视频剪辑作为输入,VisTR直接按顺序输出视频中每个实例的遮罩序列。

核心是一种新的,有效的实例序列匹配和分段策略,该策略在整个序列级别上对实例进行监督和分段。VisTR从相似性学习的同一角度构建实例分割和跟踪,从而大大简化了总体流程,并且与现有方法大不相同。

在没有花哨的情况下,VisTR可以在所有现有VIS模型中实现最高速度,并且可以在YouTubeVIS数据集上使用单一模型的方法中获得最佳效果。第一次,作者展示了一个基于Transformers的更简单,更快的视频实例分割框架,从而获得了竞争性的准确性。作者希望VisTR能够激励未来的研究,以开展更多的视频理解任务

7、Semi-supervised Domain Adaptation based on Dual-level Domain Mixing for Semantic Segmentation(基于双层域混合的半监督域自适应语义分割)

paper链接:https://arxiv.org/pdf/2103.04705.pdf

尽管在许多任务中都取得了巨大成功,但基于数据驱动的方法在应用于看不见的图像域时泛化能力很差,并且需要昂贵的注释成本,尤其是对于密集像素预测任务(例如语义分割)而言。最近,已经研究了来自大量合成数据的无监督域自适应(UDA)和具有少量标记数据的半监督学习(SSL)来缓解此问题。但是,与受监督的同行相比,绩效仍然存在很大差距。

我们将重点放在半监督域自适应(SSDA)的更实际的设置上,其中一小部分标记的目标数据和大量标记的源数据都可用。为了解决SSDA的任务,提出了一种基于双层域混合的新型框架。

拟议的框架包括三个阶段:

首先,提出了两种数据混合方法来分别减小区域级和样本级的域间隙。我们可以分别从整体视图和局部视图的双层混合数据中获得两个互补的领域混合教师。

然后,通过从这两位老师那里提炼知识来学习学生模型。

最后,以自训练的方式生成未标记数据的伪标签,以进行另外几轮教师培训。

大量的实验结果证明了我们提出的框架在合成到真实语义分割基准测试中的有效性。

8、Learning Statistical Texture for Semantic Segmentation(学习用于语义分割的统计纹理)

paper链接:https://arxiv.org/pdf/2103.04133.pdf

现有的语义分割工作主要集中在利用CNN来学习具有高级语义特征的上下文信息。为了保持精确的边界,将低级纹理特征直接跳过连接到更深的层中。尽管如此,纹理特征不仅与局部结构有关,而且还包括输入图像的全局统计知识。在本文中,作者充分利用了低级纹理特征的优势,并提出了一种用于语义分割的新型统计纹理学习网络(STLNet)。 STLNet首次分析了底层信息的分布,并有效地将其用于任务。

具体而言,一种新颖的量化和计数算子(QCO)被设计为以统计方式描述纹理信息。基于QCO引入了两个模块:(1)纹理增强模块(TEM),用于捕获与纹理有关的信息并增强纹理细节; (2)金字塔纹理特征提取模块(PTFEM),可有效地从多个尺度上提取统计纹理特征。

通过广泛的实验,我们证明了所提出的STLNet在三个语义分割基准上达到了最先进的性能:Cityscapes,PASCAL Context和ADE20K。

9、Multi-Source Domain Adaptation with Collaborative Learning for Semantic Segmentation(多源领域自适应与协作学习的语义分割)

paper链接:https://arxiv.org/pdf/2103.04717.pdf

多源无监督域自适应(MSDA)旨在将在多个标记的源域上训练的模型适配为一个未标记的目标域。在本文中,我们提出了一种基于协作学习的语义分割新的多源域自适应框架。

首先,引入一种简单的图像转换方法来对齐像素值分布,以在一定程度上减小源域和目标域之间的间隙。

然后,为了充分利用跨源域的基本语义信息,我们提出了一种用于域自适应的协作学习方法,而无需查看目标域中的任何数据。另外,类似于无监督域适应的设置,未标记的目标域数据被利用来进一步提高域适应的性能。这是通过用集成模型在线生成的伪标签另外约束多个适应模型的输出来实现的。

在语义分割中,对广泛使用的域自适应基准数据集进行了广泛的实验和消融研究。通过对标记的Synscapes和GTA5数据集以及未标记的Cityscapes训练集进行训练,我们提出的方法在Cityscapes的验证集上达到了59.0%的mIoU。它明显优于所有以前的最新的单源和多源无监督域自适应方法。

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「计算机视觉工坊」公众号后台回复:深度学习,即可下载深度学习算法、3D深度学习、深度学习框架、目标检测、GAN等相关内容近30本pdf书籍。

下载2

在「计算机视觉工坊」公众号后台回复:计算机视觉,即可下载计算机视觉相关17本pdf书籍,包含计算机视觉算法、Python视觉实战、Opencv3.0学习等。

下载3

在「计算机视觉工坊」公众号后台回复:SLAM,即可下载独家SLAM相关视频课程,包含视觉SLAM、激光SLAM精品课程。

重磅!计算机视觉工坊-学习交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有ORB-SLAM系列源码学习、3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、深度估计、学术交流、求职交流等微信群,请扫描下面微信号加群,备注:”研究方向+学校/公司+昵称“,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进去相关微信群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、orb-slam3等视频课程)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~